Googlebot, ce visiteur mystérieux qui fait la pluie et le beau temps sur votre SEO… Vous savez, ce petit robot qui vient farfouiller sur votre site pour décider si vous méritez d’être en première page ou au fin fond des résultats de recherche. Flippant, non ? 😱 Et si je vous disais que vous pouvez lire dans ses pensées (ou presque) ?

Beaucoup de webmasters, peut-être vous aussi, naviguent un peu à vue quand il s’agit de comprendre ce que Googlebot fabrique réellement sur leurs pages. On publie du contenu, on optimise des balises, on croise les doigts… mais ce qui se passe en coulisses reste souvent un grand point d’interrogation. C’est un peu comme organiser une super soirée et ne pas savoir si l’invité d’honneur est bien arrivé et s’il s’amuse !

Heureusement, il existe une solution pour lever le voile : l’analyse de logs SEO. C’est votre meilleure alliée pour comprendre en détail le comportement de Googlebot et des autres robots d’exploration. 🕵️♀️

Dans cet article, je vais vous prendre par la main pour vous expliquer clairement ce qu’est l’analyse de logs, pourquoi c’est absolument crucial pour votre référencement, et surtout, quels sont les meilleurs outils pour décortiquer le passage de Googlebot sur votre site. Préparez-vous à devenir un pro de l’espionnage SEO (éthique, bien sûr 😉) et à prendre enfin le contrôle !

L’Analyse de logs SEO : C’est quoi au juste et pourquoi C’est VITAL ? 🔍

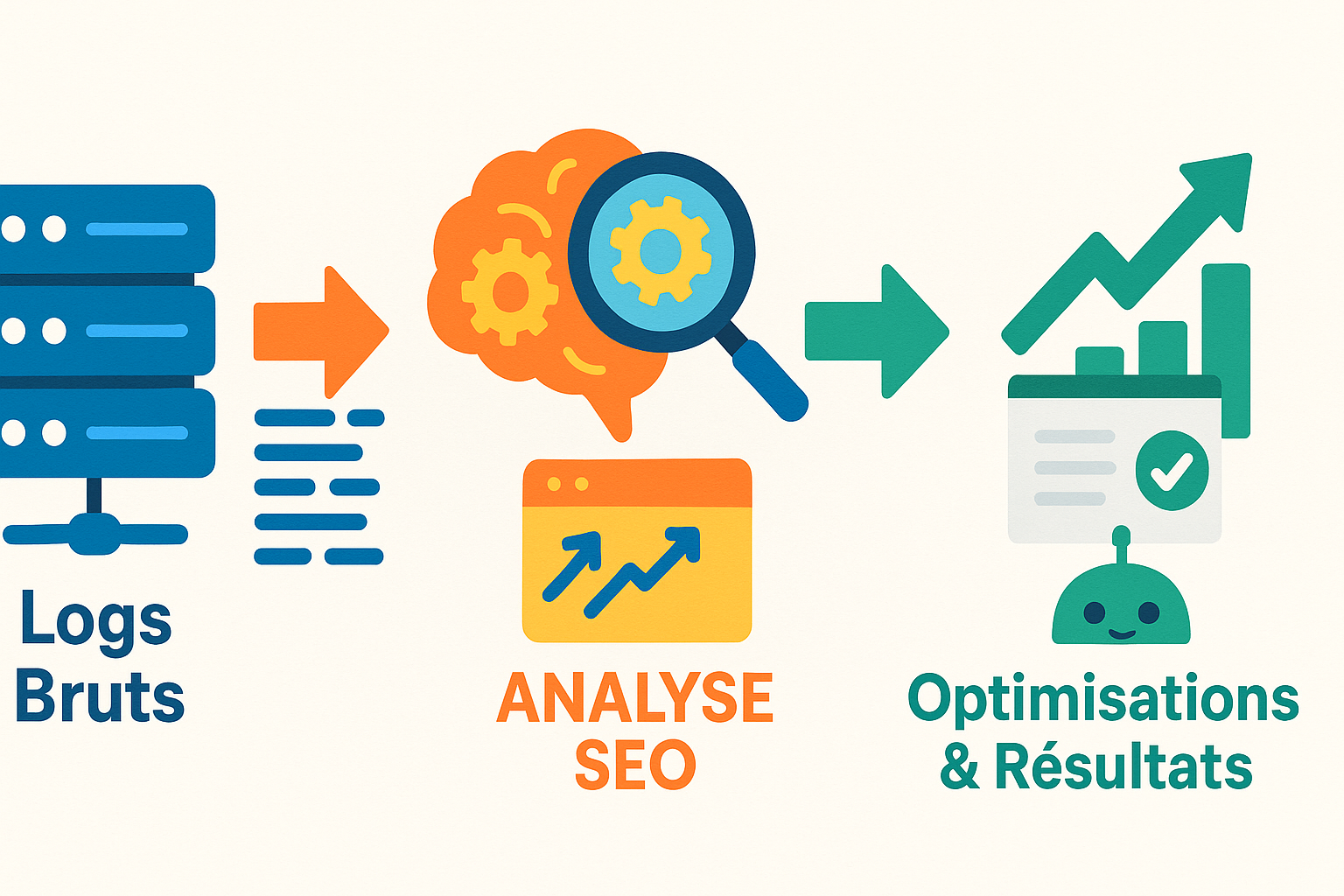

Alors, l’analyse de logs SEO, qu’est-ce que c’est concrètement ? Imaginez que votre serveur web tienne un journal de bord ultra-détaillé. Chaque fois qu’un visiteur (humain ou robot) accède à une page, une image, un fichier CSS, bref, n’importe quelle ressource de votre site, le serveur note qui a demandé quoi, quand, et comment ça s’est passé. Ce journal, ce sont les fichiers logs.

L’analyse de logs SEO consiste donc à récupérer ces fichiers bruts (qui peuvent faire un peu peur au premier abord, je l’avoue 😅) et à les « traduire » en informations compréhensibles et surtout, actionnables pour votre stratégie SEO.

Concrètement, qu’est-ce que ces logs vous apprennent sur ce filou de Googlebot ?

- Quelles pages il visite (et celles qu’il ignore royalement) : Vous pensiez que votre super nouvelle page produit était sa priorité ? Les logs vous diront la vérité, parfois cruelle !

- À quelle fréquence il passe prendre le café (ou crawler en urgence) : Certains contenus sont-ils visités tous les jours, d’autres une fois par mois ? Ces infos sont d’or.

- Les erreurs qu’il rencontre (et qui plombent votre SEO) : Pages introuvables (les fameuses erreurs 404), problèmes serveur (les erreurs 5xx)… Googlebot déteste ça, et vous devriez aussi !

- Comment il « dépense » votre précieux budget de crawl : Oui, Google alloue un « budget » de ressources pour explorer votre site. Si ce budget est gaspillé sur des pages inutiles, vos pages importantes risquent de ne pas être crawlées assez souvent.

Les bénéfices CLAIRS pour votre site sont énormes :

- Détecter les problèmes techniques invisibles à l’œil nu : Une redirection qui boucle ? Des pages importantes qui renvoient une erreur 500 ? Les logs vous alertent. D’ailleurs, si vous vous demandez comment surveiller et détecter automatiquement les erreurs 500 avec PHP, j’ai justement un article là-dessus !

- Optimiser le crawl pour une meilleure indexation : En facilitant la vie de Googlebot, vous augmentez vos chances de voir vos pages importantes indexées rapidement et correctement. Et qui dit meilleure indexation, dit potentiellement plus de trafic ! 📈

- Prendre des décisions SEO basées sur des FAITS, pas des suppositions : Fini le doigt mouillé ! Vous avez des données concrètes pour prioriser vos actions SEO.

Mon conseil de pro 💡: Ne sous-estimez JAMAIS la puissance des logs. C’est souvent là que se cachent les « quick wins » les plus impactants pour votre SEO technique. Beaucoup de consultants SEO facturent (très cher) des audits qui reposent en grande partie sur ces analyses. Avec les bons outils et un peu de méthode, vous pouvez faire une grosse partie du travail vous-même !

Googlebot en mode agent secret : comment il explore votre site (les bases à maîtriser) 🤖

Avant de plonger tête baissée dans les outils d’analyse de logs, il est crucial de comprendre comment Googlebot, notre agent secret préféré, décide de ce qu’il va explorer (ou « crawler ») sur votre site. Pensez à ces éléments comme aux instructions de mission que vous lui donnez. Si elles sont claires, sa mission (et votre SEO) se portera bien mieux !

Le fichier robots.txt : votre premier filtre pour Googlebot

Le fichier robots.txt, c’est un peu le portier de votre site. C’est un simple fichier texte que vous placez à la racine de votre domaine (par exemple, www.votresite.com/robots.txt) et qui donne des directives aux robots d’exploration comme Googlebot. Vous pouvez lui dire : « Hey, Googlebot, cette section de mon site, c’est privé, n’y va pas ! » ou « Tu peux explorer tout ce que tu veux ici, sauf ce dossier spécifique. »

Pourquoi c’est important pour l’analyse de logs ? Si vous voyez dans vos logs que Googlebot tente d’accéder à des zones que vous avez bloquées via le robots.txt, c’est un signal. Soit votre fichier robots.txt est mal configuré, soit Googlebot trouve des liens vers ces zones ailleurs (et il est curieux !).

Attention à ne pas se tirer une balle dans le pied 🦶 avec ce fichier ! Une mauvaise directive et vous pourriez bloquer l’accès à des pages cruciales. Si vous utilisez Google Tag Manager et que vous souhaitez affiner la manière dont les robots interagissent avec certaines pages, par exemple pour une balise « noindex », j’ai un guide sur comment implémenter la balise robots noindex avec Google Tag Manager qui pourrait vous éclairer sur la gestion fine des directives aux robots.

Le sitemap XML : la carte au trésor pour les robots 🗺️

Si le robots.txt dit où ne PAS aller, le sitemap XML, lui, dit où ALLER. C’est une liste des URLs de votre site que vous considérez importantes et que vous souhaitez voir explorées et indexées par les moteurs de recherche. C’est littéralement une carte au trésor pour Googlebot, l’aidant à découvrir rapidement vos contenus, surtout les nouvelles pages ou celles qui sont profondément enfouies dans l’architecture de votre site.

Lien avec l’analyse de logs ? En comparant les URLs de votre sitemap avec celles effectivement crawlées par Googlebot (visibles dans les logs), vous pouvez voir si Googlebot « boude » certaines de vos pages importantes ou, au contraire, s’il découvre bien tout ce que vous lui proposez.

Le fameux « budget de crawl » : pourquoi Google ne passera pas sa vie sur votre site (et comment l’optimiser) ⏱️

Imaginez que Googlebot ait un nombre limité d’heures à consacrer à votre site chaque jour : c’est ça, le budget de crawl. Ce budget est déterminé par plusieurs facteurs, notamment la taille de votre site, sa « santé » (peu d’erreurs), sa popularité (autorité) et la fréquence à laquelle vous mettez à jour votre contenu.

Google ne va pas crawler indéfiniment toutes vos pages tous les jours, surtout si votre site est énorme. Il va donc prioriser. L’objectif est de s’assurer qu’il utilise ce temps précieux sur vos pages les plus importantes et les plus qualitatives.

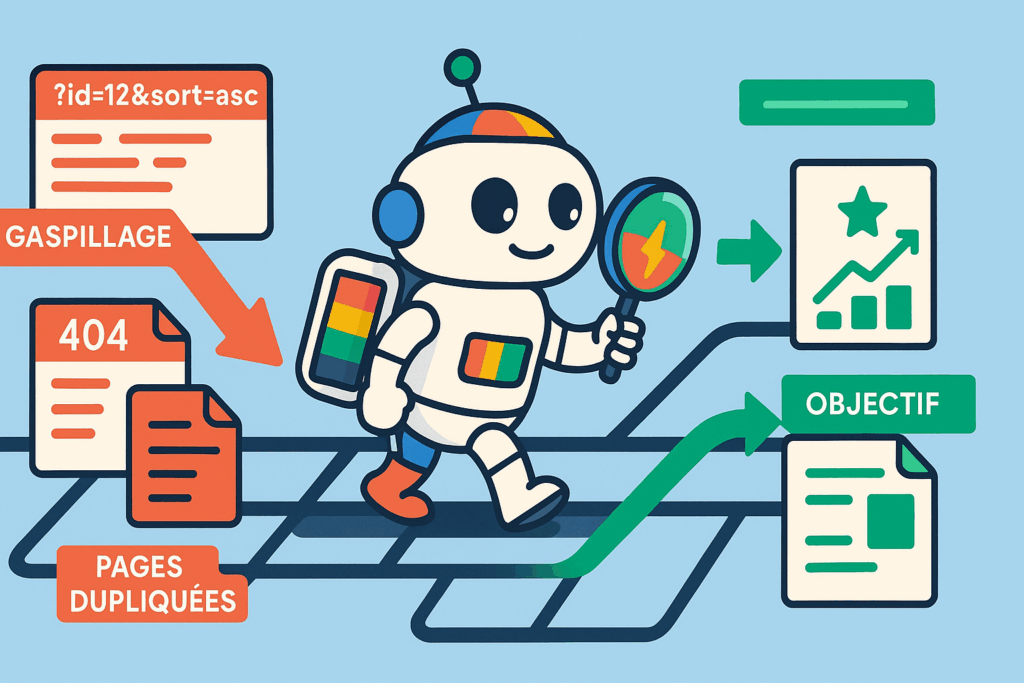

Et les logs dans tout ça ? L’analyse de logs est ESSENTIELLE pour comprendre comment votre budget de crawl est dépensé. Vous pourriez découvrir que Googlebot passe un temps fou sur :

- Des pages avec des paramètres d’URL inutiles (

votresite.com/produit?source=email&session=123). - Des pages dupliquées.

- Des pages de faible qualité que vous aviez oubliées.

- Des erreurs en boucle.

En identifiant ce gaspillage, vous pouvez prendre des mesures (corrections techniques, directives robots.txt plus précises, amélioration du maillage interne) pour réorienter Googlebot vers le contenu qui compte vraiment. Optimiser ce budget est un levier SEO technique puissant, surtout pour les gros sites. Un bon point de départ est souvent de réaliser un audit SEO technique pour crawler votre site et identifier les premières pistes d’optimisation du crawl.

Mon avis de renard 🦊 : Beaucoup de SEO se concentrent sur les mots-clés et le contenu (et ils ont raison, c’est la base !), mais négligent complètement l’aspect « exploration ». Si Googlebot ne peut pas accéder efficacement à votre contenu génial, ou s’il perd son temps sur des pages sans intérêt, tous vos efforts de contenu seront vains. Pensez à l’expérience de crawl de Googlebot comme à l’UX de vos utilisateurs humains : elle doit être fluide !

À l’attaque ! les meilleurs outils d’analyse de logs SEO passés au crible 🛠️

Maintenant que vous savez pourquoi espionner Googlebot est si important, passons aux choses sérieuses : les outils qui vont vous transformer en véritable détective du SEO. Il existe pas mal d’options sur le marché, des outils spécialisés aux grosses plateformes SEO qui intègrent cette fonctionnalité. Accrochez-vous, je vous présente mes préférés !

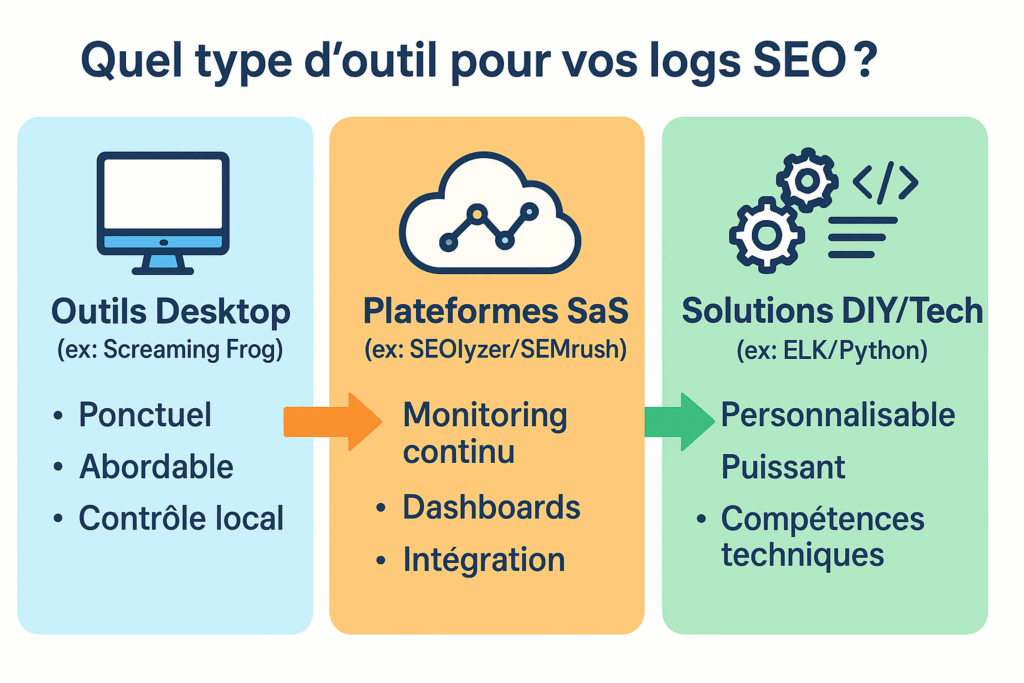

Outils « Standalone » / Desktop : les spécialistes focus

Ces outils sont souvent dédiés à l’analyse de logs ou à l’audit technique. Ils sont à installer sur votre ordinateur (pour la plupart) et nécessitent que vous importiez vos fichiers logs manuellement.

Screaming Frog SEO Log File Analyser

Présentation : Si vous connaissez déjà le crawler Screaming Frog SEO Spider (le roi pour les audits techniques !), vous serez en terrain connu. Leur Log File Analyser est un outil distinct, mais tout aussi efficace, dédié spécifiquement à l’analyse de vos fichiers logs serveur.

Points forts :

- Interface familière pour les habitués de Screaming Frog.

- Relativement abordable (une version gratuite existe avec des limitations, et la version payante est une licence unique).

- Rapide et efficace pour traiter des fichiers logs de taille conséquente directement sur votre machine.

Fonctionnalités clés pour Googlebot :

- Identification précise des URLs crawlées par les bots.

- Fréquence de crawl et dates du dernier passage.

- Codes de statut HTTP rencontrés par Googlebot.

- Données sur les user-agents pour vérifier que c’est bien Googlebot (et pas un faux !).

- Possibilité de comparer les URLs des logs avec une liste d’URLs (par exemple, issues d’un crawl ou d’un sitemap).

🐸 Mon avis express sur Screaming Frog Log File Analyser : C’est un excellent point de départ ! Si vous débutez dans l’analyse de logs ou si vos besoins sont ponctuels, c’est l’outil idéal. Il est puissant sans être une usine à gaz. Pour moi, c’est un must-have dans la boîte à outils du SEO qui veut aller au-delà des analyses de surface.

SEOlyzer

Présentation : SEOlyzer est un outil d’analyse de logs SEO en mode SaaS, souvent plébiscité pour son approche en temps réel (ou quasi) et ses visualisations de données. Il se concentre sur l’impact SEO de vos logs.

Points forts :

- Monitoring en continu (selon la configuration).

- Tableaux de bord clairs et orientés « actions ».

- Segmentation avancée des URLs et des bots.

- Détection des problèmes de crawl et d’indexation.

Fonctionnalités clés pour Googlebot :

- Suivi du comportement de Googlebot sur les pages stratégiques.

- Analyse de la performance de crawl (pages actives vs. pages inactives crawlées).

- Identification du gaspillage de budget de crawl.

- Alertes en cas de problèmes critiques (chute du crawl, augmentation des erreurs).

🧐 Mon avis express sur SEOlyzer : Un très bon outil pour ceux qui veulent un suivi plus automatisé et des rapports visuels. Il est particulièrement utile pour les sites e-commerce ou les médias qui ont besoin de réactivité. Si vous voulez des graphiques qui parlent d’eux-mêmes pour convaincre votre boss, c’est une piste sérieuse !

Plateformes SEO tout-en-un avec module d’analyse de logs : la puissance intégrée

Ces plateformes bien connues des professionnels du SEO proposent une myriade d’outils, et certaines incluent un module d’analyse de logs. L’avantage ? Centraliser vos données et croiser les informations plus facilement.

SEMrush Log File Analyzer

Présentation : SEMrush est une véritable machine de guerre du marketing digital. Son outil Log File Analyzer s’intègre dans cette suite pour vous permettre de comprendre comment les moteurs de recherche interagissent avec votre site. Si vous cherchez un avis plus global sur la plateforme, j’ai justement un article détaillé : mon avis sur SEMrush, l’outil SEO tout-en-un est-il vraiment complet ?

Points forts :

- Intégration avec les autres outils SEMrush (audit de site, suivi de position, etc.).

- Interface utilisateur soignée et bien structurée.

- Bonnes capacités de filtrage et de tri des données.

Fonctionnalités clés pour Googlebot :

- Rapport sur l’activité de Googlebot (et autres bots majeurs).

- Détection des erreurs les plus fréquentes rencontrées par les bots.

- Analyse de l’efficacité du crawl (combien de pages crawlées, avec quelle fréquence).

- Visualisation des URLs les plus et les moins actives pour Googlebot.

🏆 Mon avis express sur SEMrush Log File Analyzer : Si vous êtes déjà un utilisateur de SEMrush, c’est une évidence de tester cette fonctionnalité. La force réside dans la capacité à croiser les données de logs avec toutes les autres informations SEO que la plateforme fournit. C’est un gain de temps et d’efficacité non négligeable !

Oncrawl

Présentation : Oncrawl est une plateforme SEO technique puissante qui combine un crawler, un analyseur de logs et des connecteurs de données (Analytics, Search Console…). Elle est particulièrement réputée pour les analyses poussées sur les gros sites web.

Points forts :

- Très forte capacité d’analyse pour les sites complexes et à forte volumétrie.

- Segmentation et croisement de données extrêmement avancés.

- Focus sur l’impact du SEO technique (budget de crawl, contenu dupliqué, architecture…).

- Rapports personnalisables et détaillés.

Fonctionnalités clés pour Googlebot :

- Analyse fine du budget de crawl et détection des gaspillages.

- Compréhension de la manière dont Googlebot découvre et explore le contenu (y compris le JavaScript).

- Suivi de l’état de santé de l’indexation.

- Identification des « stalemates » (pages importantes non crawlées).

🚀 Mon avis express sur Oncrawl : C’est la Rolls-Royce pour les SEO techniques et les entreprises qui gèrent des sites avec des millions d’URLs. Si vous avez besoin de creuser très, très loin dans vos données de crawl et de logs pour trouver des optimisations millimétrées, Oncrawl est probablement fait pour vous. Prévoyez une courbe d’apprentissage, mais la puissance est au rendez-vous.

Botify

Présentation : Similaire à Oncrawl dans son positionnement « entreprise » et « gros sites », Botify est une autre plateforme de premier plan pour l’analyse SEO technique, combinant crawl, logs et données de performance. Elle met un accent particulier sur l’impact business du SEO.

Points forts :

- Excellente capacité à gérer et analyser de très grands volumes de données.

- Analyses prédictives (par exemple, sur l’impact potentiel de modifications techniques).

- Très orienté « ROI » et performance.

- Bonne intégration avec d’autres sources de données.

Fonctionnalités clés pour Googlebot :

- Compréhension granulaire du parcours de Googlebot, du premier hit au rendu final.

- Analyse de l’indexation réelle et des écarts avec le contenu crawlable.

- Optimisation du « speed to market » pour les nouveaux contenus.

- Suivi de l’impact des optimisations sur le comportement de Googlebot.

💡 Mon avis express sur Botify : Si vous travaillez pour une grande entreprise où chaque optimisation SEO doit être justifiée par un impact business chiffré, Botify est un allié de poids. C’est une solution très complète et sophistiquée pour une stratégie SEO data-driven à grande échelle. Comme Oncrawl, attendez-vous à un certain investissement en temps et en argent.

Solutions Alternatives et pour les Tech-Savvy : pour les aventuriers du code et de la data 🤓

Si vous avez l’âme d’un développeur ou d’un data scientist, ou si vous avez des besoins très spécifiques (et un budget potentiellement plus serré pour les outils « clés en main »), ces options pourraient vous intéresser.

ELK Stack (Elasticsearch, Logstash, Kibana) / Splunk

Présentation : Ce ne sont pas des outils SEO à la base, mais des plateformes de gestion et d’analyse de logs généralistes extrêmement puissantes. Elasticsearch est un moteur de recherche et d’analyse, Logstash s’occupe de la collecte et du traitement des logs, et Kibana permet de visualiser les données. Splunk est une alternative commerciale très populaire dans le monde de l’IT.

Points forts :

- Ultra-personnalisable : vous construisez votre propre solution d’analyse.

- Capacité à gérer des volumes de données absolument massifs.

- Peut être (relativement) gratuit si vous hébergez et configurez ELK vous-même.

- Possibilité d’intégrer d’autres sources de données.

Fonctionnalités clés pour Googlebot : Tout ce que vous pouvez imaginer… si vous savez comment le configurer ! Vous pouvez créer des dashboards sur mesure pour suivre chaque aspect du crawl de Googlebot.

🔧 Mon avis express sur ELK / Splunk : C’est l’option pour les équipes avec de solides compétences techniques (DevOps, Data Analysts) ou pour ceux qui ont un besoin impérieux de flexibilité totale et qui ne trouvent pas leur bonheur dans les outils standards. La courbe d’apprentissage est raide, mais le potentiel est immense.

Scripts Python personnalisés

Présentation : Si vous êtes à l’aise avec le code, pourquoi ne pas créer vos propres scripts d’analyse ? Python, avec ses bibliothèques comme Pandas pour la manipulation de données et Matplotlib/Seaborn pour la visualisation, est un excellent choix.

Points forts :

- Contrôle total sur le processus d’analyse.

- Gratuit (hormis votre temps de développement).

- Adaptabilité maximale à vos besoins spécifiques.

Fonctionnalités clés pour Googlebot : Celles que vous programmez ! Par exemple, identifier les pics de crawl, les erreurs fréquentes, les types de fichiers les plus demandés par Googlebot, etc. Si vous êtes curieux de savoir comment utiliser Python pour l’analyse de données, j’ai un tutoriel sur Google Colab pour utiliser Python qui pourrait être un bon point de départ.

🐍 Mon avis express sur les scripts Python : Pour les SEO qui aiment mettre les mains dans le cambouis et qui ne sont pas effrayés par quelques lignes de code. C’est une approche très formatrice et qui peut s’avérer très puissante pour des analyses sur mesure. Parfait pour les budgets serrés et les esprits curieux !

Ouf ! Ça fait pas mal d’outils, n’est-ce pas ? 😅 L’idée n’est pas de tous les maîtriser, mais de savoir qu’ils existent et de choisir celui qui correspond le mieux à VOS besoins. Et c’est justement ce qu’on va voir dans la prochaine partie !

Quel outil choisir sans se ruiner (ni s’arracher les cheveux) ? 🤔

Face à cette jungle d’outils, vous vous demandez sûrement : « Ok, c’est bien beau tout ça, mais lequel est FAIT POUR MOI ?! » Pas de panique, c’est une question légitime. Le meilleur outil d’analyse de logs SEO n’est pas le plus cher ou le plus complexe, mais celui qui répond le mieux à vos besoins spécifiques, à votre budget, et à votre niveau de confort technique. 🧘

Pour vous aider à faire le tri, voici quelques questions clés à vous poser avant de dégainer la carte bleue (ou de vous lancer dans l’installation d’un usine à gaz) :

1. Votre budget ? 💰

C’est souvent le nerf de la guerre !

- Gratuit / Très Abordable : Si votre budget est serré, Screaming Frog Log File Analyser (avec sa version gratuite limitée mais fonctionnelle, ou sa licence payante unique très raisonnable) est un excellent point de départ. Les scripts Python personnalisés sont aussi une option « gratuite » si vous avez les compétences.

- Budget Moyen : Des outils comme SEOlyzer ou l’utilisation du Log File Analyzer de SEMrush (si vous avez déjà un abonnement pour d’autres besoins) peuvent entrer dans cette catégorie.

- Premium / Entreprise : Oncrawl et Botify sont clairement positionnés sur le segment des solutions plus coûteuses, mais justifiées par leur puissance et leur niveau de service pour les grands comptes et les besoins très complexes.

2. La taille de votre site et la volumétrie de vos logs ? 💾

Un blog personnel ne génère pas la même quantité de logs qu’un site e-commerce international !

- Petits à moyens sites : Screaming Frog Log File Analyser, SEOlyzer, ou même des scripts Python peuvent très bien faire l’affaire. Le module de SEMrush sera aussi suffisant.

- Gros sites / Très forte volumétrie : C’est là que la robustesse d’Oncrawl, Botify, ou d’une solution customisée type ELK Stack devient indispensable. Ces outils sont conçus pour ingérer et analyser des gigaoctets, voire des téraoctets de données de logs sans broncher.

3. Vos compétences techniques ? 🤓

Soyez honnête avec vous-même !

- Débutant / Pas très technique : Optez pour des outils avec une interface graphique claire et une prise en main relativement simple. Screaming Frog Log File Analyser ou le module de SEMrush sont de bons candidats. SEOlyzer, avec ses dashboards, est aussi assez accessible.

- Intermédiaire / À l’aise avec les concepts SEO techniques : Vous pourrez exploiter plus en profondeur des outils comme Oncrawl ou Botify, même si une phase d’apprentissage est nécessaire.

- Expert / Développeur / Data Analyst : Les solutions type ELK Stack ou les scripts Python vous offriront une flexibilité et une puissance inégalées, mais demandent un investissement technique important.

4. Les fonctionnalités indispensables pour VOUS ? ✨

Tous les outils ne se valent pas sur tous les aspects.

- Analyse ponctuelle vs. Monitoring en continu : Si vous voulez juste faire un « état des lieux » de temps en temps, un outil desktop comme Screaming Frog suffit. Pour un suivi en temps réel et des alertes, SEOlyzer ou les plateformes plus complètes sont plus indiquées.

- Besoin de croiser les données : Si vous voulez absolument intégrer vos données de logs avec d’autres métriques SEO (positions, backlinks, données Google Analytics/Search Console), les plateformes tout-en-un comme SEMrush, Oncrawl ou Botify ont un avantage. Il est d’ailleurs très pertinent de pouvoir analyser les données de logs en parallèle de ce que vous voyez dans la Search Console. Pour cela, savoir comment connecter Google Search Console à Looker Studio peut vous donner des idées pour centraliser vos visualisations.

- Visualisation des données : Si vous êtes très sensible aux rapports graphiques et aux dashboards visuels, SEOlyzer, Oncrawl, Botify, ou une solution Kibana bien configurée seront plus satisfaisants.

- Spécificités pour sites e-commerce ou médias : Certains outils sont plus adaptés pour analyser le crawl des pages produits avec facettes, ou la fraîcheur du crawl pour des articles d’actualité.

🚀 Mon conseil de pro pour bien démarrer : Commencez simple, surtout si c’est votre première incursion dans le monde des logs ! Il vaut mieux maîtriser un outil plus basique et en tirer de réelles informations actionnables que de se perdre dans une usine à gaz trop complexe pour vos besoins actuels. Screaming Frog SEO Log File Analyser est souvent cité comme un excellent premier choix, car il est relativement facile à prendre en main, abordable, et fournit déjà une mine d’informations. Vous pourrez toujours évoluer vers des solutions plus avancées par la suite si le besoin s’en fait sentir. L’important est de mettre le pied à l’étrier et de commencer à explorer ces données précieuses !

En répondant à ces questions, vous devriez déjà avoir une idée plus précise du type d’outil qui pourrait vous convenir. N’hésitez pas à profiter des essais gratuits ou des démos quand c’est possible pour vous faire votre propre opinion avant de vous engager.

Les indicateurs clés à espionner dans vos logs pour dompter Googlebot 📊

Vous avez choisi votre arme (votre outil d’analyse de logs préféré 😉), vous avez vos fichiers logs sous la main… C’est l’heure de jouer les détectives ! Mais que chercher exactement ? Quels sont les indices qui vont vous révéler les secrets de Googlebot et vous aider à optimiser votre site ? Voici les indicateurs clés (KPIs) que je vous conseille de scruter à la loupe.

1. Fréquence de crawl par section de site / type de page

Ce que ça vous dit : Googlebot ne traite pas toutes vos pages de la même manière. Certaines sont visitées plusieurs fois par jour, d’autres une fois par semaine, voire moins. Analyser la fréquence de crawl vous permet de voir :

- Si vos pages les plus importantes (accueil, catégories phares, nouveaux articles/produits) sont crawlées suffisamment souvent.

- Si des sections moins importantes ou obsolètes de votre site mobilisent trop l’attention de Googlebot.

- L’impact de vos mises à jour : une nouvelle publication ou une modification majeure attire-t-elle rapidement Googlebot ?

Pourquoi c’est crucial : Si vos pages stratégiques ne sont pas crawlées régulièrement, vos mises à jour mettront plus de temps à être prises en compte, et leur performance SEO pourrait en pâtir. Inversement, si Googlebot perd du temps sur des pages sans importance, c’est du budget de crawl gaspillé.

2. Codes de statut HTTP (les messagers de votre serveur)

Ce que ça vous dit : Chaque fois que Googlebot (ou n’importe quel client) demande une URL, le serveur répond avec un code de statut HTTP. Les plus courants à surveiller dans vos logs sont :

- 200 OK : Tout va bien, la page a été servie avec succès. C’est ce que vous voulez voir pour vos pages importantes !

- 301 Moved Permanently : Redirection permanente. Googlebot va suivre la redirection et transférer la « notoriété » de l’ancienne URL vers la nouvelle. Vérifiez qu’elles pointent vers la bonne destination.

- 302 Found / 307 Temporary Redirect : Redirection temporaire. À utiliser avec parcimonie, car elles ne transfèrent pas toujours la notoriété aussi bien que les 301.

- 404 Not Found : La page n’existe pas (ou plus). Un grand nombre de 404 crawlées par Googlebot peut indiquer des problèmes de liens internes cassés, des erreurs dans votre sitemap, ou des pages supprimées sans redirection.

- 403 Forbidden : Googlebot n’a pas l’autorisation d’accéder à cette page. Vérifiez vos configurations serveur.

- 500 Internal Server Error : Problème côté serveur. Googlebot n’a pas pu accéder à la page à cause d’une erreur serveur. C’est grave et à corriger d’urgence !

- 503 Service Unavailable : Le serveur est temporairement indisponible (maintenance, surcharge). Si Googlebot rencontre ça trop souvent, il pourrait réduire sa fréquence de crawl.

Pourquoi c’est crucial : Les erreurs 4xx et 5xx sont de mauvais signaux envoyés à Google. Elles dégradent l’expérience de crawl et peuvent entraîner une baisse de l’exploration de votre site, voire des problèmes d’indexation. Les redirections doivent être correctement configurées pour ne pas perdre Googlebot en route.

3. Pages les plus (et les moins !) crawlées : y a-t-il des surprises ?

Ce que ça vous dit : Votre outil d’analyse de logs vous montrera quelles URLs reçoivent le plus de « visites » de Googlebot. Comparez cette liste avec votre liste de pages stratégiques (celles qui doivent générer du trafic et des conversions).

- Vos pages piliers sont-elles bien dans le top des pages crawlées ?

- Y a-t-il des pages inattendues qui sont très souvent crawlées (par exemple, des pages de mentions légales ou des filtres de recherche sans intérêt SEO) ?

- À l’inverse, certaines de vos pages importantes sont-elles boudées par Googlebot ?

Pourquoi c’est crucial : C’est un excellent moyen de vérifier l’alignement entre votre stratégie de contenu et l’attention réelle de Googlebot. Vous pourriez découvrir des pépites à optimiser ou, au contraire, des gouffres à budget de crawl. Comprendre quelles pages sont explorées (ou non) est fondamental, notamment pour s’assurer que vos landing pages conçues pour convertir sont bien visibles par les moteurs.

4. Identification du gaspillage de budget de crawl

Ce que ça vous dit : C’est l’une des utilisations les plus rentables de l’analyse de logs. Vous cherchez les endroits où Googlebot passe du temps inutilement :

- Paramètres d’URL : URLs avec des

?id_session=,?source=,?tri=, etc., qui génèrent des URLs dupliquées ou de faible valeur. - Contenu dupliqué : Plusieurs URLs qui servent le même contenu (ou très similaire).

- Pages non canoniques crawlées : Si vous utilisez des balises

rel="canonical", vérifiez que Googlebot crawle principalement les versions canoniques. - Redirections en chaîne : Une URL A redirige vers B, qui redirige vers C… Chaque redirection consomme du budget.

- Pages « soft 404 » : Des pages qui renvoient un code 200 OK mais dont le contenu est vide ou indique une erreur.

Pourquoi c’est crucial : Chaque « hit » de Googlebot sur une page inutile est un hit qui n’est pas fait sur une page importante. Optimiser le budget de crawl, c’est s’assurer que Googlebot se concentre sur ce qui compte pour votre business.

5. Crawl des nouvelles pages : Google les découvre-t-il rapidement ?

Ce que ça vous dit : Quand vous publiez un nouvel article de blog, une nouvelle fiche produit, ou une nouvelle landing page, vous voulez que Google la découvre et l’indexe le plus vite possible. Vos logs vous indiquent le délai entre la publication et le premier passage de Googlebot.

Pourquoi c’est crucial : Un délai de découverte trop long peut être frustrant et retarder l’acquisition de trafic sur vos nouveaux contenus. Si c’est le cas, vérifiez votre sitemap XML, votre maillage interne vers ces nouvelles pages, et la fréquence de crawl globale de votre site.

🕵️♀️ Mon astuce d’enquêteur : Ne vous contentez pas de regarder les chiffres globaux. Segmentez ! La plupart des outils permettent de filtrer par type de bot (Googlebot, Bingbot, autres), par type de contenu (HTML, images, CSS, JS), par section de site (si votre structure d’URL le permet). C’est en creusant dans ces segments que vous trouverez les informations les plus croustillantes ! Par exemple, Googlebot explore-t-il beaucoup vos fichiers JavaScript ? Cela peut être normal pour le rendu, mais une activité excessive pourrait indiquer des problèmes.

En surveillant régulièrement ces indicateurs, vous commencerez à avoir une compréhension très fine de la relation entre Googlebot et votre site. Vous serez capable d’identifier les problèmes avant qu’ils ne deviennent critiques et de prendre des décisions d’optimisation bien plus éclairées. 💡

Au-delà des outils : pistes pour chouchouter Googlebot et votre SEO ❤️

Avoir les meilleurs outils d’analyse de logs et savoir quels indicateurs surveiller, c’est déjà énorme. Bravo, vous êtes sur la bonne voie pour devenir un maître espion de Googlebot ! 🕵️♂️ Mais l’analyse de logs n’est qu’une partie de l’équation. Pour vraiment optimiser le passage de Googlebot et, par extension, votre SEO, il faut aussi mettre en place des bonnes pratiques sur votre site. Pensez-y comme préparer votre maison pour un invité de marque : vous voulez que tout soit impeccable et facile d’accès !

1. L’importance capitale d’une bonne structure de site

Une structure de site logique et claire n’aide pas seulement vos utilisateurs humains, elle facilite aussi grandement la tâche de Googlebot. Si votre site est un labyrinthe sans fin, Googlebot risque de s’y perdre, de manquer des pages importantes ou de gaspiller son budget de crawl.

- Hiérarchie claire : Organisez votre contenu de manière logique avec des catégories et sous-catégories bien définies.

- Profondeur limitée : Essayez de faire en sorte que vos pages importantes ne soient pas à plus de 3-4 clics de la page d’accueil.

- URLs propres et descriptives : Des URLs comme

votresite.com/categorie/nom-produitsont plus parlantes pour Googlebot (et pour les humains) quevotresite.com/cat123/prd456.php?id=789.

Analyser vos logs peut justement vous révéler si Googlebot peine à atteindre certaines profondeurs de votre site.

2. Le maillage interne : guidez Googlebot vers vos pages stratégiques

Le maillage interne, c’est l’art de créer des liens entre les pages de votre propre site. C’est CRUCIAL pour plusieurs raisons :

- Distribution du « jus de lien » (PageRank) : Les liens internes aident à diffuser l’autorité de vos pages les plus fortes vers d’autres pages.

- Aide à la découverte : Ils permettent à Googlebot de découvrir de nouvelles pages ou des pages plus profondes.

- Contexte sémantique : Les ancres de liens donnent des indications à Google sur le sujet des pages liées.

En analysant vos logs, si vous voyez que des pages importantes sont peu crawlées, un maillage interne défaillant pourrait être en cause. Assurez-vous de lier vos contenus de manière pertinente. Une bonne stratégie de contenu s’appuie aussi sur un maillage réfléchi, par exemple en liant vos articles de blog vers vos pages de service ou vos contenus ciblant la longue traîne.

3. La vitesse de chargement : ne faites pas attendre Googlebot (ni vos utilisateurs !) 💨

Google l’a dit et répété : la vitesse de chargement est un facteur de classement. Mais c’est aussi important pour le crawl. Si vos pages sont lentes à charger, Googlebot passera plus de temps à récupérer chaque page, ce qui peut réduire le nombre total de pages qu’il peut crawler dans son budget imparti.

- Optimisez vos images.

- Utilisez la mise en cache du navigateur.

- Minifiez votre code (CSS, JavaScript, HTML).

- Choisissez un hébergement performant.

Des temps de réponse serveur élevés visibles dans les logs sont un signal d’alarme.

4. La qualité et la fraîcheur du contenu : donnez-lui une bonne raison de revenir 🌟

Googlebot a tendance à visiter plus souvent les sites qui publient régulièrement du contenu frais et de haute qualité. Si votre contenu est pertinent, utile et mis à jour, Google aura tout intérêt à revenir fréquemment pour s’assurer de ne rien manquer.

- Publiez régulièrement.

- Mettez à jour vos anciens articles avec de nouvelles informations.

- Évitez le contenu dupliqué ou de faible qualité.

L’analyse de logs peut vous montrer si la fréquence de crawl augmente après la publication de nouveaux contenus de qualité.

5. Un audit SEO technique régulier : la prévention avant tout

L’analyse de logs est une facette de l’audit SEO technique, mais un audit plus global est aussi essentiel. Cela inclut la vérification de l’indexation, l’analyse des erreurs de la Search Console, l’optimisation mobile, la gestion des balises (canoniques, hreflang, etc.). Un site techniquement sain est un site plus facile à crawler. Vous pouvez vous aider de différents outils pour réaliser un audit SEO technique et crawler votre site afin de déceler des problèmes qui pourraient affecter le passage de Googlebot.

💡 Pensez « Expérience Robot » ! On parle beaucoup d’Expérience Utilisateur (UX), et c’est fondamental. Mais je vous encourage aussi à penser à l' »Expérience Robot » (RX ? 🤔). Si votre site est rapide, bien structuré, sans erreurs bloquantes, et avec un maillage interne intelligent, vous rendez la vie de Googlebot tellement plus simple. Et un Googlebot heureux est souvent synonyme d’un meilleur SEO !

En combinant une analyse de logs rigoureuse avec ces bonnes pratiques, vous mettez toutes les chances de votre côté pour que Googlebot explore votre site de manière efficace, découvre vos meilleurs contenus, et in fine, contribue à améliorer votre visibilité dans les résultats de recherche. C’est un travail de longue haleine, mais les résultats en valent la peine !

Votre prochain coup d’éclat SEO : passez à l’action ! 🚀

Et voilà, nous avons fait un sacré tour d’horizon du monde fascinant de l’analyse de logs SEO et de notre cher Googlebot ! Vous savez maintenant que derrière ces lignes de code un peu austères se cache une véritable mine d’or d’informations pour comprendre comment le géant de la recherche interagit avec votre site. 🕵️♀️

Pour résumer, vous avez maintenant les clés pour :

- Comprendre ce qu’est l’analyse de logs et pourquoi c’est essentiel.

- Connaître les bases du fonctionnement de Googlebot (

robots.txt, sitemap, budget de crawl). - Identifier les meilleurs outils du marché, adaptés à vos besoins et à votre budget.

- Savoir quels indicateurs précis surveiller pour déceler les problèmes et les opportunités.

- Mettre en place des bonnes pratiques pour chouchouter Googlebot.

Alors, mon message pour vous est simple : n’ayez plus peur des fichiers logs, ils sont vos amis ! Oui, ça peut sembler un peu technique au début, mais avec le bon outil et un peu de méthode, vous allez vite y prendre goût, surtout quand vous verrez les premiers résultats concrets sur votre SEO.

Mon dernier conseil de Sioux 🦉 : Choisissez UN outil pour commencer (Screaming Frog Log File Analyser est souvent un excellent point de départ, je le répète !). Obtenez vos premiers fichiers logs (demandez à votre hébergeur si besoin). Importez-les. Et commencez à explorer. Cherchez les erreurs 404, regardez vos pages les plus crawlées… Même de petites découvertes peuvent avoir un grand impact. L’important, c’est de se lancer !

L’analyse de logs, c’est un peu comme avoir une conversation directe avec Googlebot. Il vous dit ce qu’il aime, ce qui le bloque, où il passe son temps. Écoutez-le attentivement, et vous serez largement récompensé par une meilleure indexation, un trafic plus qualifié et, au final, plus de succès pour votre site web. C’est une des bonnes pratiques SEO fondamentales, surtout pour les PME qui veulent tirer le meilleur de leur présence en ligne.

Alors, prêt à enfiler votre chapeau de détective SEO ? 🕵️

Et vous, quel est votre outil d’analyse de logs préféré ou quelle est la première chose que vous allez vérifier après avoir lu cet article ? Partagez votre expérience ou vos questions dans les commentaires ci-dessous ! 👇